- Registriert

- 6 Mai 2021

- Beiträge

- 2.584

- Erhaltene Likes

- 6.326

Temperaturen aus Vergleichstest sind immer schwer zu beurteilen für den eigenen Gebrauch. Wenn er da ein kleines Gehäuse mit wenig Lüftern und ner fetten CPU gleich über der Grafikkarte sein Eigen nennt, dann wird die Karte gewiss nicht auf 40°C ideln, wenn in der Kiste so schon 45°C sind.

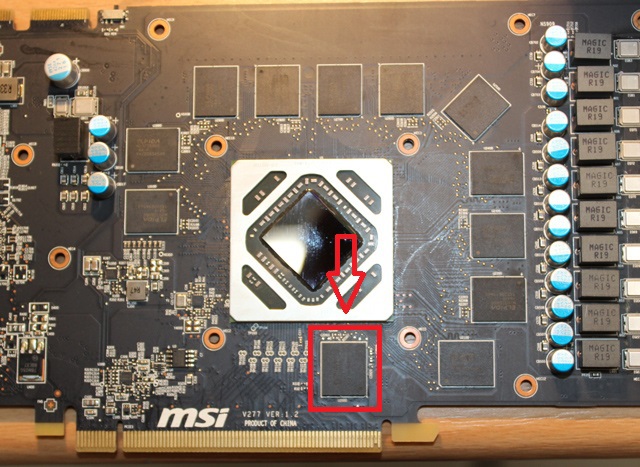

Nichts desto trotz kann nach so langer Zeit sicher nicht mal eine Erneuerung der Paste zwischen Kühler und GPU schaden. Manchmal wird halt schon übelstes Zeug dazwischen gedrückt. Hatte ich hier auch eine. Da war das Zeug so trocken, da bekommste eher ne Staublunge von als gute Kühlung.

Nichts desto trotz kann nach so langer Zeit sicher nicht mal eine Erneuerung der Paste zwischen Kühler und GPU schaden. Manchmal wird halt schon übelstes Zeug dazwischen gedrückt. Hatte ich hier auch eine. Da war das Zeug so trocken, da bekommste eher ne Staublunge von als gute Kühlung.