MrHonk

mit Baby Bruno

- Registriert

- 6 Mai 2021

- Beiträge

- 659

- Erhaltene Likes

- 1.134

N'Abend in die Runde.

Normalerweise würde ich ja selbst Abende lang Vergleichen und Videos schauen/Testberichte lesen bis zum Umfallen, aber dafür fehlt mir aktuell die Zeit. Und so kam ich auf die Idee euch einfach mal zu fragen. Und eine Bitte vorab @RobMitchum und @Finus04 - lasst diesen Thread bitte bitte bitte nicht zu einem AMD/Nvidia Battle zwischen euch werden - es soll wenn dann definitiv wieder eine Nvidia Karte werden und da bringt es nichts mir AMD Grafikkarten vorzuschlagen.

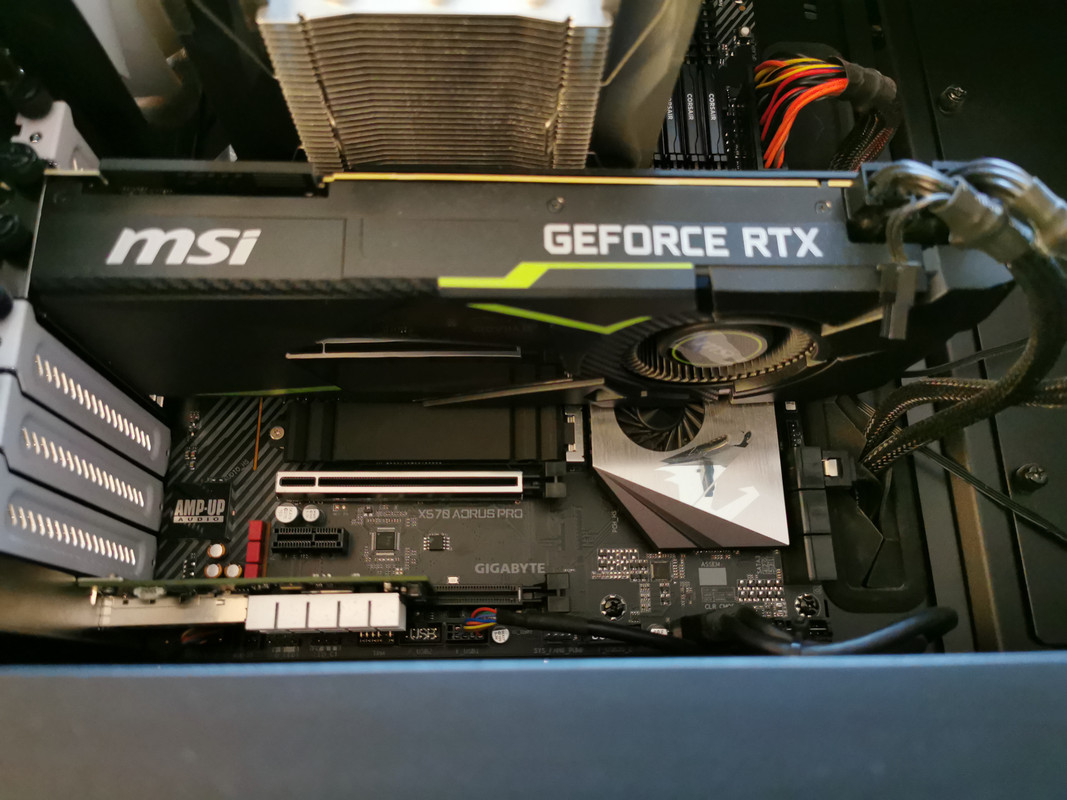

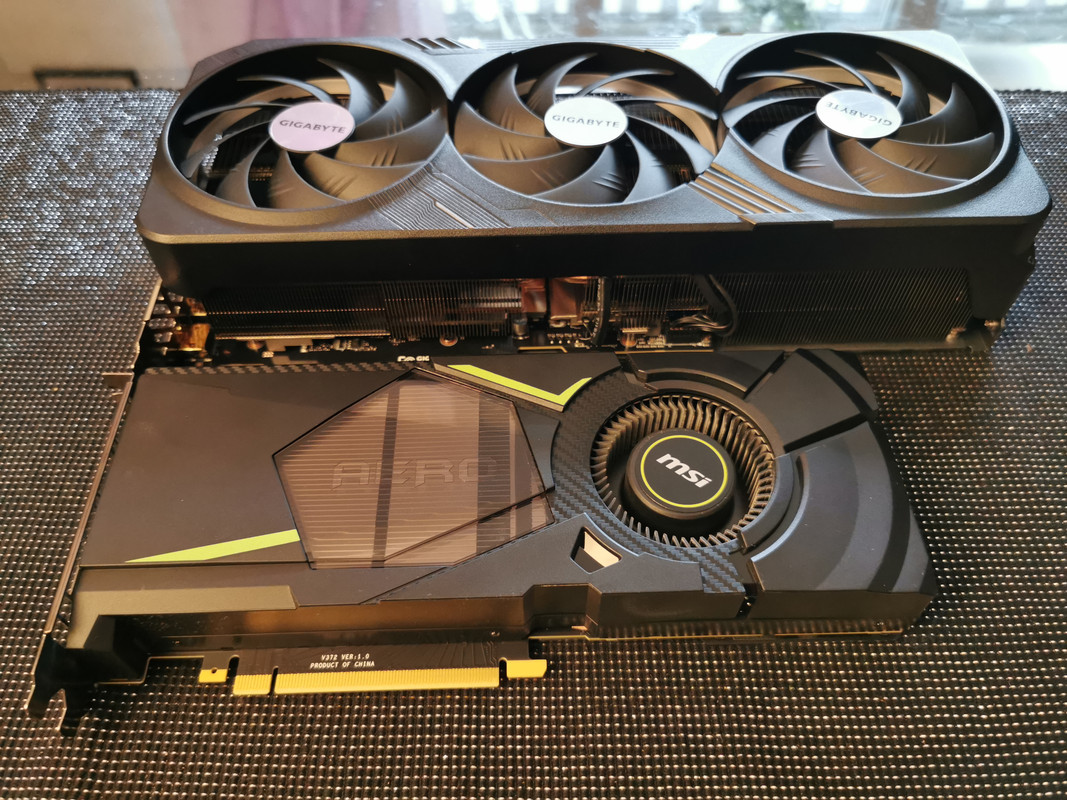

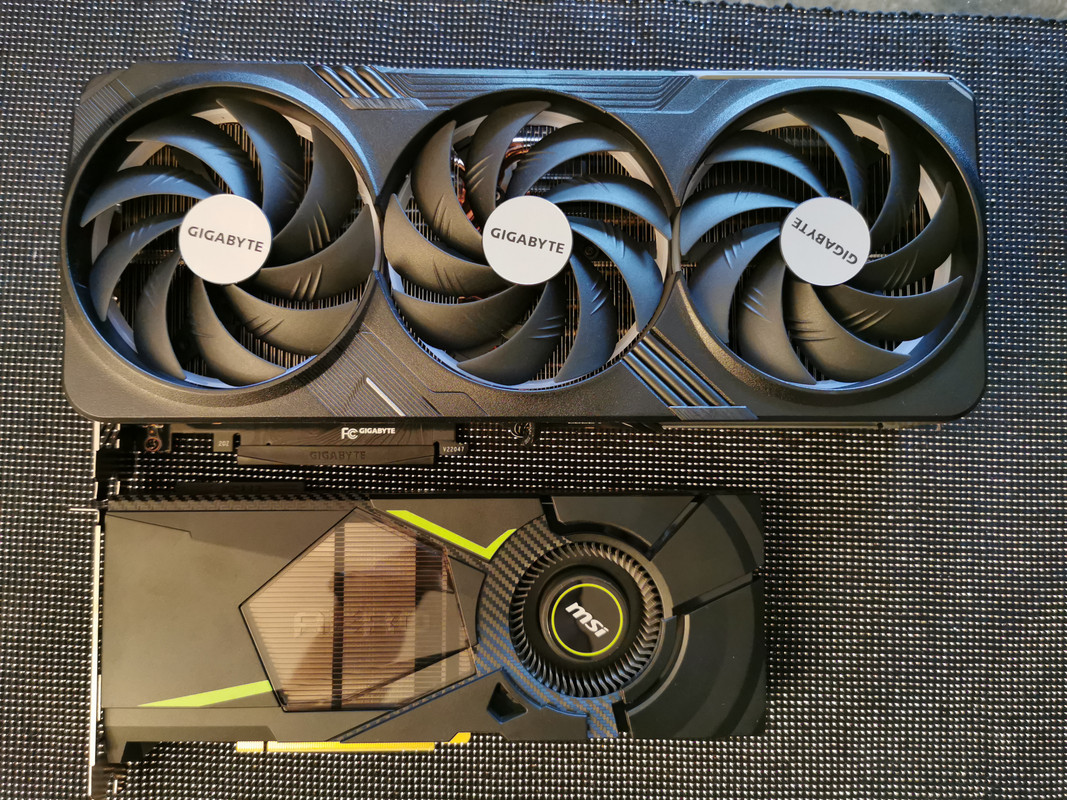

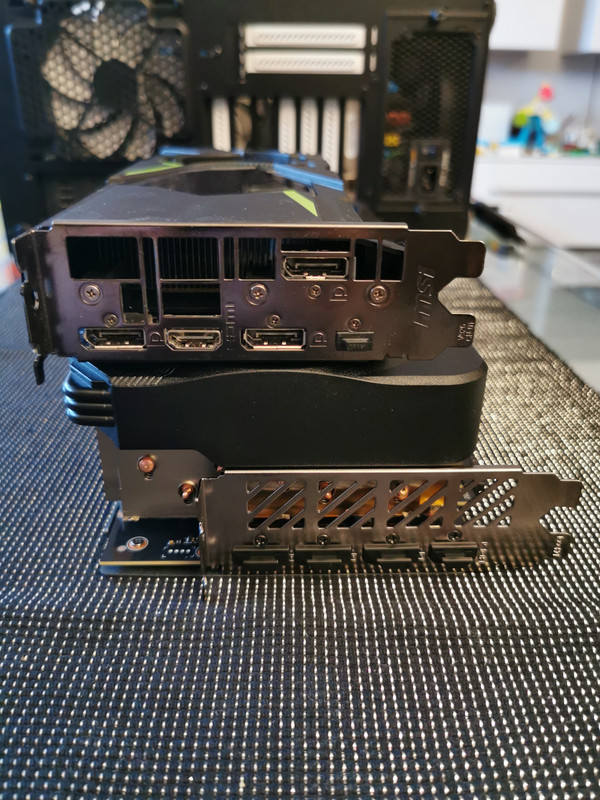

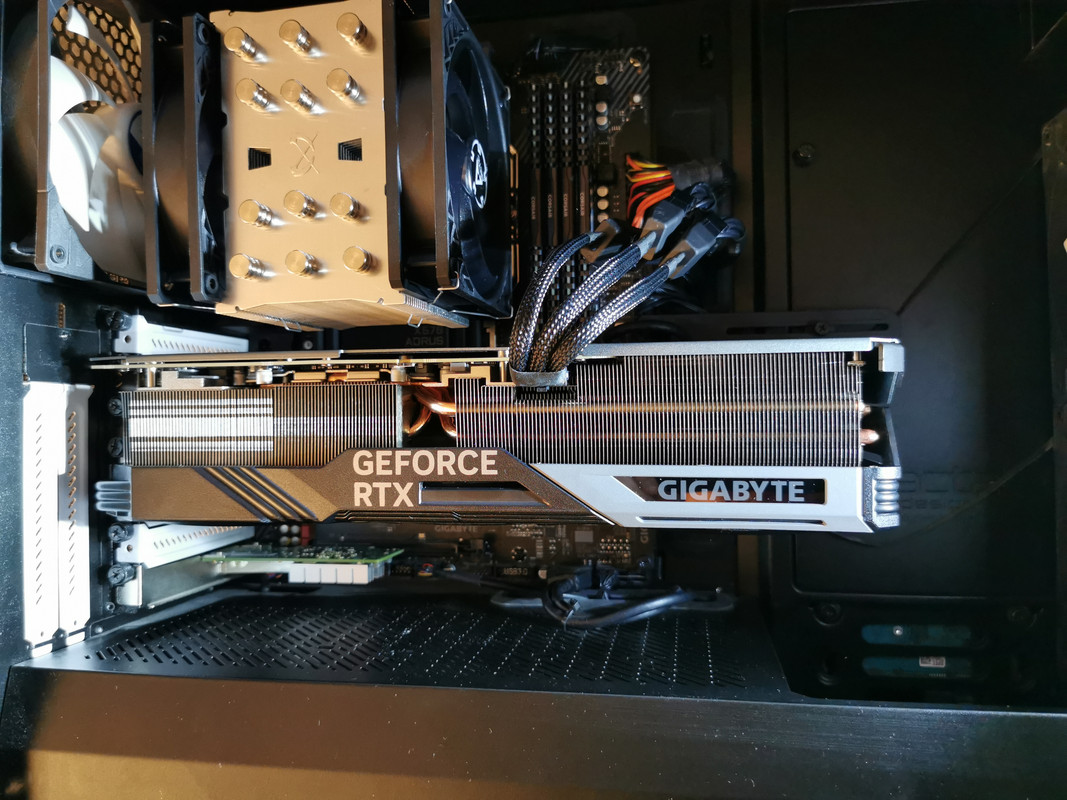

Ich spiele mit dem Gedanken meine RTX 2080 an meinen Neffen weiterzuvererben und mir selbst dann eine RTX 4080 zu kaufen. Sein Computer wurde während der Corona Pandemie zusammengebaut und da hatten wir erst einmal auf einen AMD Ryzen 3200G gesetzt, da wir nicht einsahen, für eine popelige GraKa horrende Preise zu zahlen. Bei mir würden dadurch die meisten Spiele öfter in UHD gespielt werden. Aktuell skaliere ich auf meinem UHD Monitor auf FHD runter um höhere Grafiksettings fahren zu können.

VR wird es bei mir nicht geben, ich konnte erst vor Weihnachten wieder so eine Brille ausprobieren und für mich ist das einfach nichts. Der FS2020 sieht in VR geil aus, keine Frage, aber bereits beim Anrollen und dabei Umschauen wird mir übel. Und so geil, das ich wochenlang mein Gehirn erst trainieren muss um kaum oder fast keine Motion Sickness mehr zu erleben, das ist es mir einfach nicht wert.

Welche 4080 wäre denn aktuell empfehlenswert und warum meint der Bottleneck Calculator meine CPU (Ryzen 9 3900X) würde einen Flaschenhals für eine 4080 bei UHD Gaming darstellen? Laut dem Calculator wäre ein Ryzen 9 5900X ideal für die Karte, aber so ganz nachvollziehen kann ich das bei den CPUs ehrlich gesagt nicht. Soooo alt ist der 3900X ja nun auch noch nicht, das eine nur drei Jahre jüngere Grafikkarte ihn an Limit bringen soll.

Ein neues Netzteil muss ja schon alleine schon wegen der neuen GPU-Anschlüsse bei Nvidia her, reicht da ein 750W Netzteil noch aus? Die TDP der 4080 liegt ja bei 320 W, wobei Nvidia bei der aktuellen Generation die TDP für sich neu definiert hat. War die TDP bisher ein Wert, der kurzfristig immer wieder mal überschritten werden konnte, und die GraKa meist knapp unterhalb der TDP an der Leitung nuckelte, gilt diese seit dieser Generation als das alleräußerste Maximum was die Stromaufnahme angeht und der eigentliche Durst liegt deutlich darunter.

Der Rest meines System wird beibehalten. Wenn der Wechsel der CPU auf einen 5900X spürbar sein sollte, dann würde ich das maximal noch mit in Erwägung ziehen, aber mehr wie 2.000 € +/- ein paar Euros wollte ich jetzt nicht unbedingt dafür ausgeben.

Normalerweise würde ich ja selbst Abende lang Vergleichen und Videos schauen/Testberichte lesen bis zum Umfallen, aber dafür fehlt mir aktuell die Zeit. Und so kam ich auf die Idee euch einfach mal zu fragen. Und eine Bitte vorab @RobMitchum und @Finus04 - lasst diesen Thread bitte bitte bitte nicht zu einem AMD/Nvidia Battle zwischen euch werden - es soll wenn dann definitiv wieder eine Nvidia Karte werden und da bringt es nichts mir AMD Grafikkarten vorzuschlagen.

Ich spiele mit dem Gedanken meine RTX 2080 an meinen Neffen weiterzuvererben und mir selbst dann eine RTX 4080 zu kaufen. Sein Computer wurde während der Corona Pandemie zusammengebaut und da hatten wir erst einmal auf einen AMD Ryzen 3200G gesetzt, da wir nicht einsahen, für eine popelige GraKa horrende Preise zu zahlen. Bei mir würden dadurch die meisten Spiele öfter in UHD gespielt werden. Aktuell skaliere ich auf meinem UHD Monitor auf FHD runter um höhere Grafiksettings fahren zu können.

VR wird es bei mir nicht geben, ich konnte erst vor Weihnachten wieder so eine Brille ausprobieren und für mich ist das einfach nichts. Der FS2020 sieht in VR geil aus, keine Frage, aber bereits beim Anrollen und dabei Umschauen wird mir übel. Und so geil, das ich wochenlang mein Gehirn erst trainieren muss um kaum oder fast keine Motion Sickness mehr zu erleben, das ist es mir einfach nicht wert.

Welche 4080 wäre denn aktuell empfehlenswert und warum meint der Bottleneck Calculator meine CPU (Ryzen 9 3900X) würde einen Flaschenhals für eine 4080 bei UHD Gaming darstellen? Laut dem Calculator wäre ein Ryzen 9 5900X ideal für die Karte, aber so ganz nachvollziehen kann ich das bei den CPUs ehrlich gesagt nicht. Soooo alt ist der 3900X ja nun auch noch nicht, das eine nur drei Jahre jüngere Grafikkarte ihn an Limit bringen soll.

Ein neues Netzteil muss ja schon alleine schon wegen der neuen GPU-Anschlüsse bei Nvidia her, reicht da ein 750W Netzteil noch aus? Die TDP der 4080 liegt ja bei 320 W, wobei Nvidia bei der aktuellen Generation die TDP für sich neu definiert hat. War die TDP bisher ein Wert, der kurzfristig immer wieder mal überschritten werden konnte, und die GraKa meist knapp unterhalb der TDP an der Leitung nuckelte, gilt diese seit dieser Generation als das alleräußerste Maximum was die Stromaufnahme angeht und der eigentliche Durst liegt deutlich darunter.

Der Rest meines System wird beibehalten. Wenn der Wechsel der CPU auf einen 5900X spürbar sein sollte, dann würde ich das maximal noch mit in Erwägung ziehen, aber mehr wie 2.000 € +/- ein paar Euros wollte ich jetzt nicht unbedingt dafür ausgeben.

Zuletzt bearbeitet: